之前分享过 👉 一行代码!手机秒变 AI 神器:DeepSeek 离线部署指南,通过 Termux 来安装的 Ollama,因网络问题,很多小伙伴卡在下载模型的步骤了。

今天分享这款「PocketPal AI」免费开源的手机离线部署模型应用,预置了多种轻量化模型,包括 DeepSeek-R1、Qwen、Llama、Gemma、Phi 等,并支持用户自定义加载 GGUF 格式模型。对比手机安装 Ollama,这款「PocketPal AI」还提供了内存释放机制,当应用切换至后台时自动释放模型占用的内存,返回前台时快速重新加载。

使用介绍

这款「PocketPal AI」应用提供了安卓和 iOS 版本,这里以安卓版为使用介绍,安卓端通过 MLC-LLM 等框架优化 GPU 资源调用,提升推理速度。

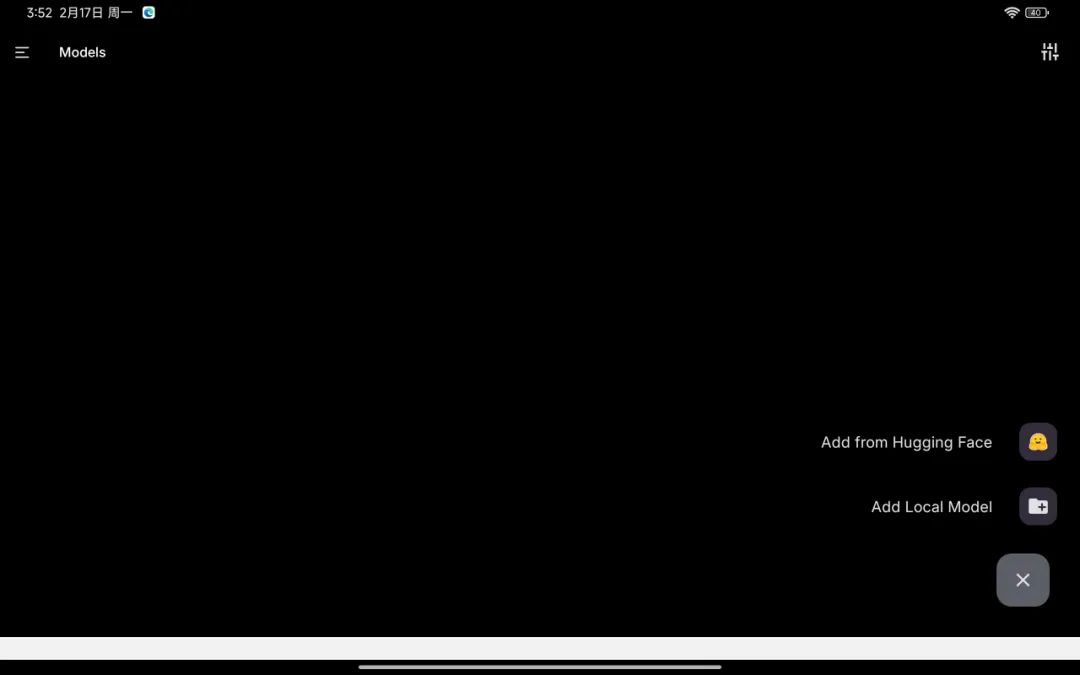

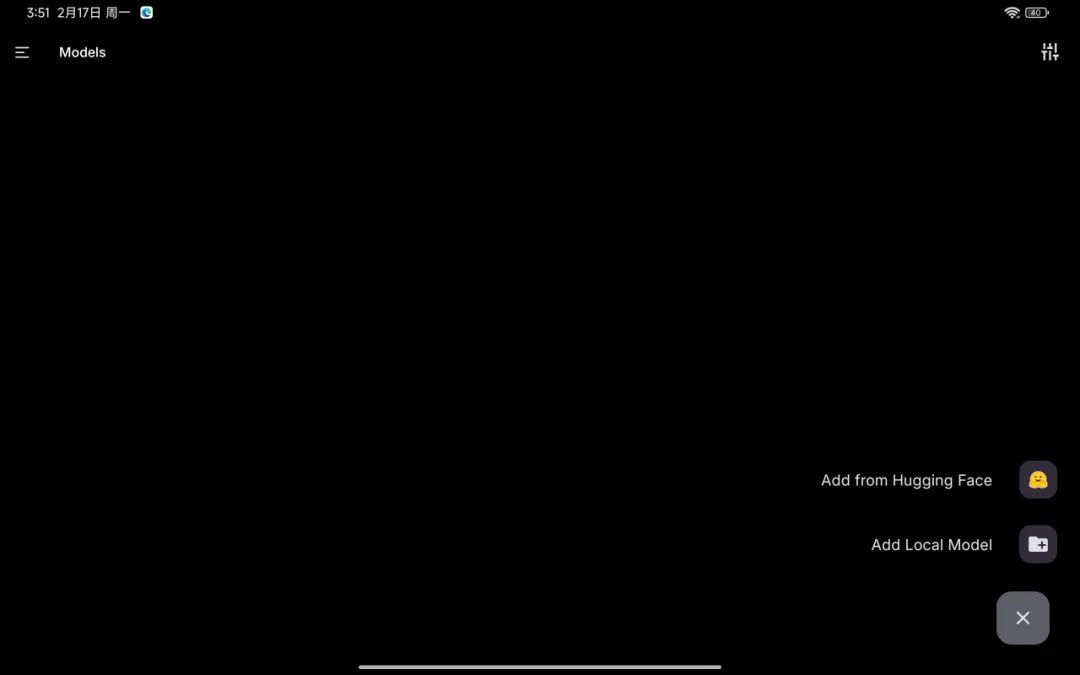

安装好后,需要先下载模型,点击 + 添加模型,支持在线下载模型,从 Add from Hugging Face 进行下载。

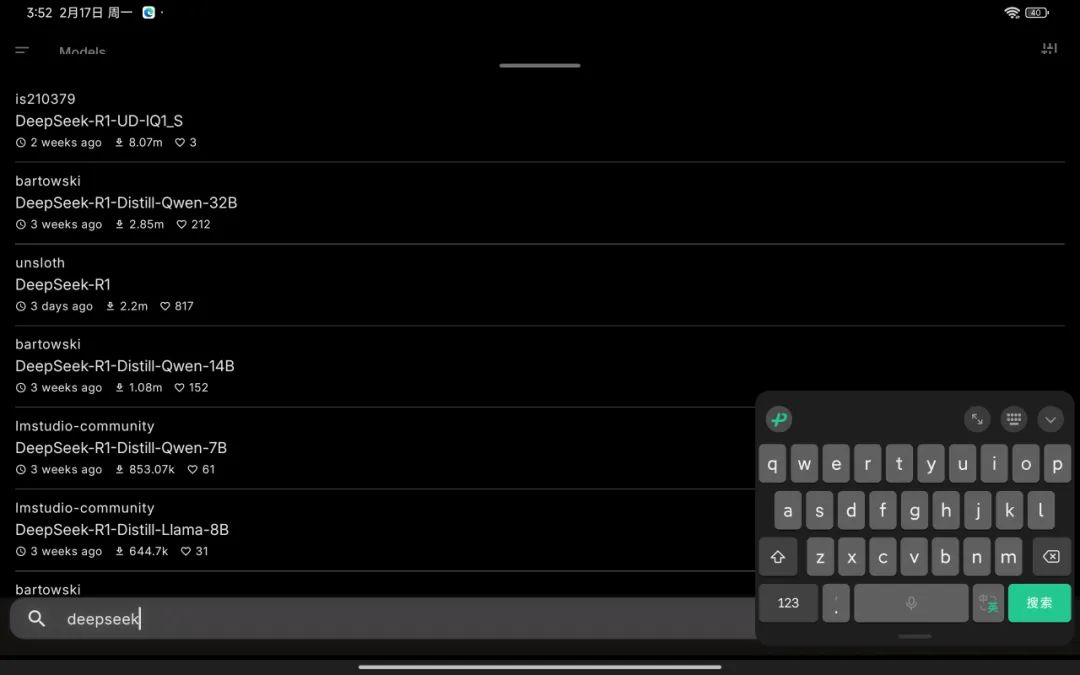

搜索关键词 DeepSeek,选择你需要的模型进行下载。不知道选择哪个模型的,可以参考这篇:👉本地部署「DeepSeek」模型硬件配置要求。不过手机端部署,建议选择 1.5B 或者 7B。

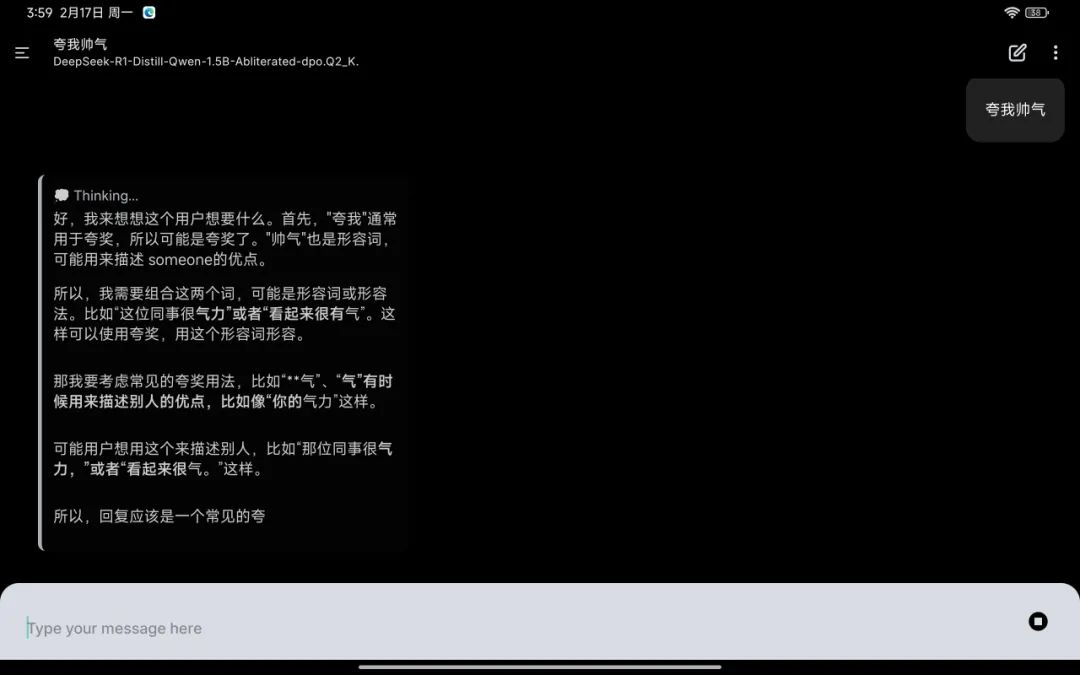

等待模型下载完毕后,在模型管理里面,点击 Load 启动。然后就可以使用离线版本 DeepSeek 了。

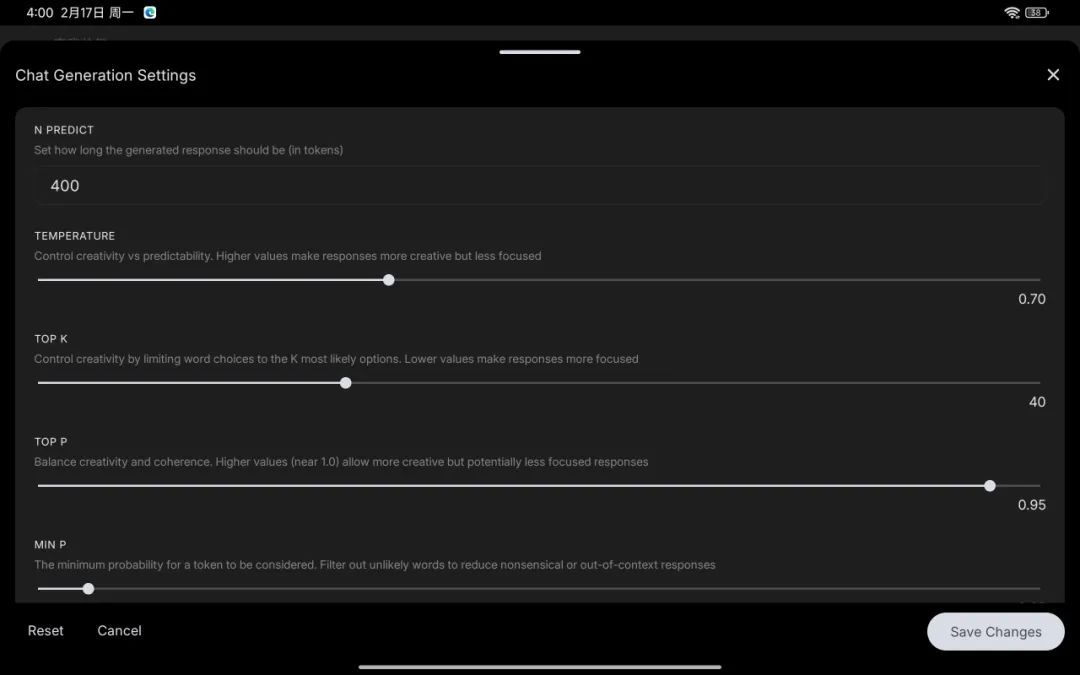

聊天生成设置功能方面,可以对上下文设置,用户可设置生成内容的最大长度,默认建议调整为 4096 或 8000,支持选择不同预置模板,实时性能指标等。

加载本地模型

如果网络问题下载不了 DeepSeek 模型,那么也可以通过本地加载 GGUF 格式模型。点击 + 本地加载模型(Add Local Model)- 载入你下载好的模型 - 模型管理 - 点击 Load 启动。

- DeepSeek模型下载:

https://pan.quark.cn/s/69b9d9440600 - 模型库:

https://modelscope.cn/models

总结

还是用在线版吧 🐶 。电脑版的也可以看这篇:👉 新手必备!免部署即用 DeepSeek 全量本地模型库。

下载地址

- 安卓版:

https://pan.quark.cn/s/a4cff696832a - iOS版:

https://apps.apple.com/cn/app/id6502579498 - DeepSeek模型下载:

https://pan.quark.cn/s/69b9d9440600 - 项目地址:

https://github.com/a-ghorbani/pocketpal-ai

👉 DeepSeek 专题:DeepSeek 部署教程 / 免费 API 服务 / 入门指南