因为「DeepSeek」是免费、开源、支持本地部署时私有的,之前教过大家👉 超简单!3 步部署国产 AI 神器「DeepSeek」到你的电脑。

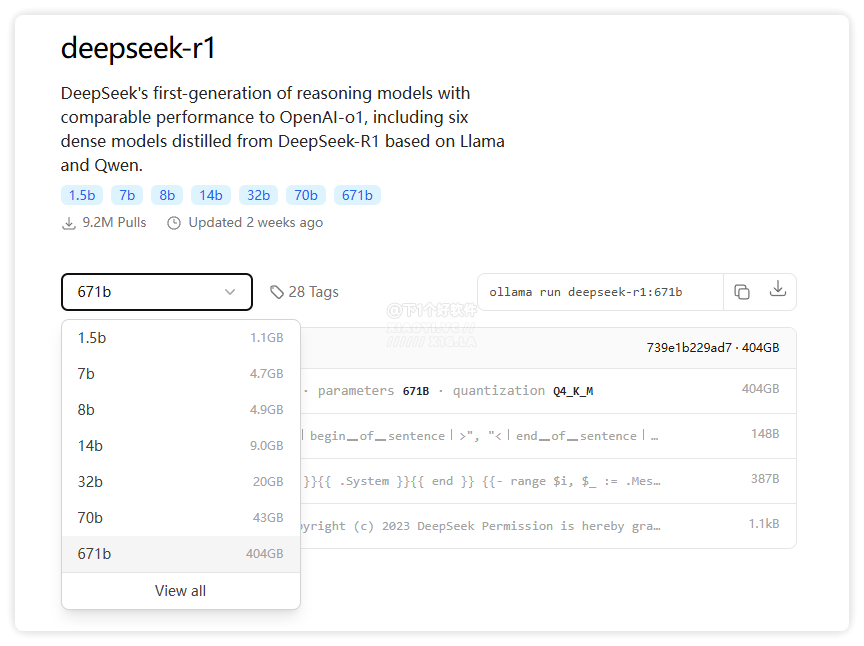

不过很多小伙伴不知道自己的电脑能不能跑得动「DeepSeek」模型,目前最新的 DeepSeek-R1 提供了多个蒸馏后的参数模型,包括有:1.5b、7b、8b、14b、32b、70b,以及满血版 671b 大模型。

这些参数模型区别主要体现在参数规模、模型容量、性能表现、准确性、训练成本、推理成本和不同使用场景。简单说就是参数规模数量越多,知识就越丰富,同时对硬件的要求也越高。

参数模型硬件要求

以下是不同参数量模型的本地部署硬件要求和适用场景分析。注:部分数据基于模型通用需求推测,具体以实际部署测试为准。

✅ DeepSeek-R1-1.5B

- CPU: 最低 4 核(推荐 Intel/AMD 多核处理器)

- 内存: 8GB+

- 硬盘: 3GB+ 存储空间(模型文件约 1.5-2GB)

- 显卡: 非必需(纯 CPU 推理),若 GPU 加速可选 4GB+ 显存(如 GTX 1650)

- 场景:低资源设备部署,如树莓派、旧款笔记本、嵌入式系统或物联网设备

✅ DeepSeek-R1-7B

- CPU: 8 核以上(推荐现代多核 CPU)

- 内存: 16GB+

- 硬盘: 8GB+(模型文件约 4-5GB)

- 显卡: 推荐 8GB+ 显存(如 RTX 3070/4060)

- 场景:中小型企业本地开发测试、中等复杂度 NLP 任务,例如文本摘要、翻译、轻量级多轮对话系统

✅ DeepSeek-R1-8B

- CPU: 8 核以上(推荐现代多核 CPU)

- 内存: 16GB+

- 硬盘: 8GB+(模型文件约 4-5GB)

- 显卡: 推荐 8GB+ 显存(如 RTX 3070/4060)

- 场景:需更高精度的轻量级任务(如代码生成、逻辑推理)

✅ DeepSeek-R1-14B

- CPU: 12 核以上

- 内存: 32GB+

- 硬盘: 15GB+

- 显卡: 16GB+ 显存(如 RTX 4090 或 A5000)

- 场景:企业级复杂任务、长文本理解与生成

✅ DeepSeek-R1-32B

- CPU: 16 核以上(如 AMD Ryzen 9 或 Intel i9)

- 内存: 64GB+

- 硬盘: 30GB+

- 显卡: 24GB+ 显存(如 A100 40GB 或双卡 RTX 3090)

- 场景:高精度专业领域任务、多模态任务预处理

✅ DeepSeek-R1-70B

- CPU: 32 核以上(服务器级 CPU)

- 内存: 128GB+

- 硬盘: 70GB+

- 显卡: 多卡并行(如 2x A100 80GB 或 4x RTX 4090)

- 场景:科研机构/大型企业、高复杂度生成任务

✅ DeepSeek-R1-671B

- CPU: 64 核以上(服务器集群)

- 内存: 512GB+

- 硬盘: 300GB+

- 显卡: 多节点分布式训练(如 8x A100/H100)

- 场景:超大规模 AI 研究、通用人工智能(AGI)探索

总结

个人或中小企业建议用 1.5B - 14B,更高的模型参数本地部署性价比极低(土豪请随意),推荐用云端部署 API 接口使用。

👉 DeepSeek 专题:DeepSeek 部署教程 / 免费 API 服务 / 入门指南