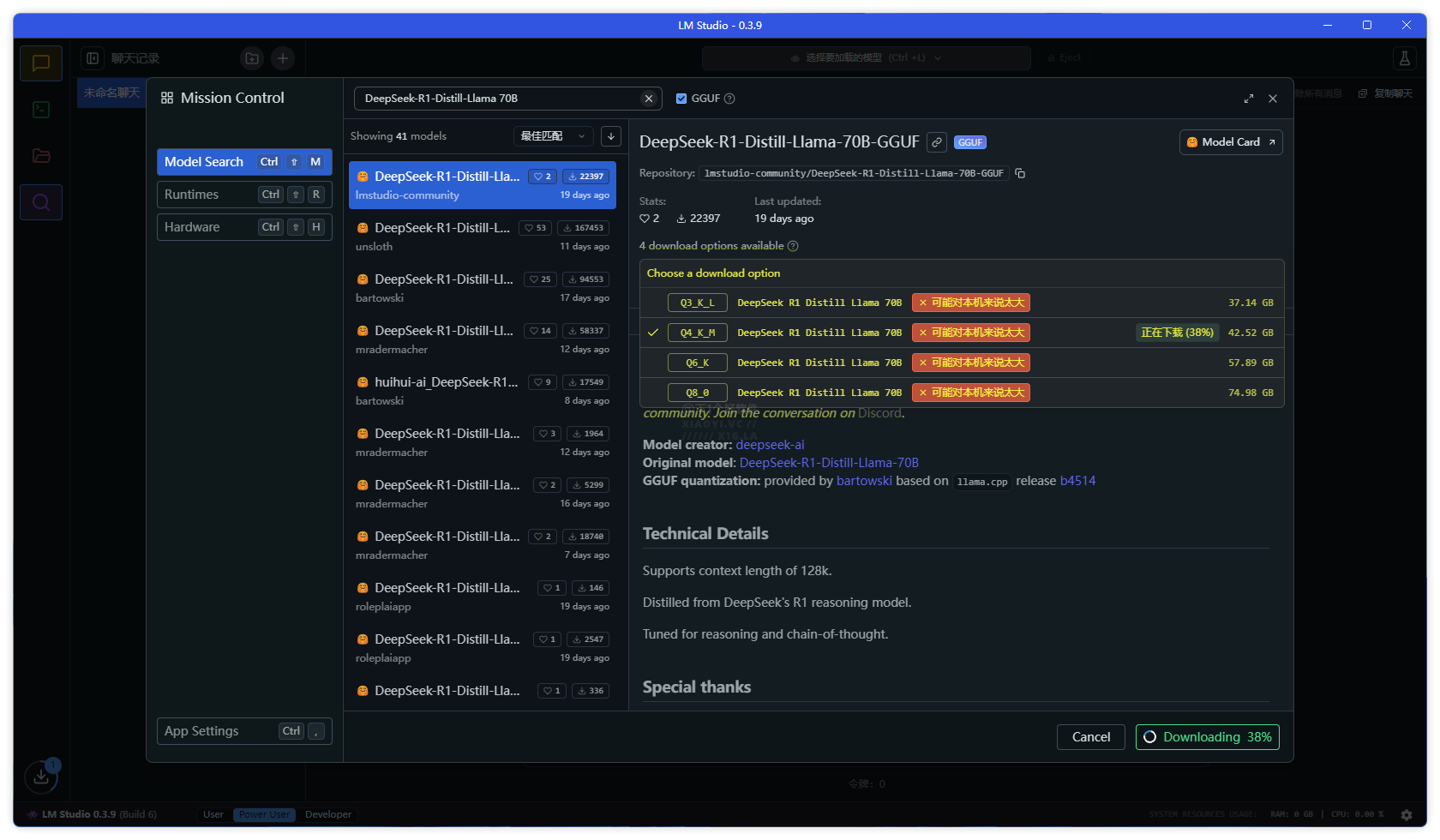

DeepSeek 开源的大模型,有些小伙伴在本地部署下载 DeepSeek 模型时会看到 Qwen 与 Llama 蒸馏模型,以及 Q2、Q3、Q4、Q5、Q8 等的代号,不知道如何选择版本。例如教过大家的👉 超简单!3 步部署国产 AI 神器「DeepSeek」到你的电脑。又或者通过 LM Studio 本地部署模型工具里面搜索到的 DeepSeek 模型有很多版本。

本文小羿给大家介绍 Qwen 与 Llama 区别,以及量化介绍,让你根据环境需求、硬件要求、是否需要更快的推理速度还是更高的精度,来选择相关的模型版本。

Qwen 与 Llama 的区别

Qwen (通义千问)

- 开发者:阿里巴巴达摩院

- 架构:基于 Transformer,支持更长上下文窗口

- 训练数据:侧重中文语料,兼顾多语言

- 应用场景:中文 NLP 任务优化

Llama (Meta)

- 开发者:Meta (Facebook)

- 架构:基于 Transformer,优化稀疏注意力机制

- 训练数据:以英文为主,涵盖部分多语言数据

- 应用场景:通用任务,适配英文环境更好

量化介绍

Q2、Q3、Q4、Q5、Q8 的代号属于模型量化技术的标识符,主要取决于量化工具(如 GGUF 格式)。量化旨在降低模型存储和计算成本,常见规则如下:

Q2_K

- 位宽:2-bit

- 精度损失:高

- 内存占用:极低

- 推理速度:极快

Q3_K_M

- 位宽:3-bit

- 精度损失:中

- 内存占用:低

- 推理速度:快

Q4_K_S

- 位宽:4-bit

- 精度损失:低

- 内存占用:中等

- 推理速度:中等

Q5_K_M

- 位宽:5-bit

- 精度损失:极低

- 内存占用:较高

- 推理速度:较慢

Q8_0

- 位宽:8-bit

- 精度损失:可忽略

- 内存占用:高

- 推理速度:慢

省流

中文处理优先选择 Qwen 版本,量化参数根据自己的需求和硬件来选(本地部署「DeepSeek」模型硬件配置要求),例如低配置电脑,优先选择 Q3_K_M 或者 Q4_K_S,也可根据推理速度需求来选一个平衡的参数模型。富哥请随意。

电脑跑不动本地 DeepSeek 模型,可以看这里:🔥满血版 DeepSeek 免费 / 限免 API 汇总!持续更新

👉 DeepSeek 专题:DeepSeek 部署教程 / 免费 API 服务 / 入门指南