最近国产 AI 神器「DeepSeek」因推出价格低廉、开源,媲美 OpenAI,并且在 1 月 27 日,苹果 App Store 中国区免费榜显示,「DeepSeek」成为中国区下载量第一,在全球引发巨大震动。

同时「DeepSeek」遭遇了前所未有的网络攻击,成为了社会热点。用户反馈使用情况变得不可预测,时而正常运行,时而速度缓慢,甚至完全无法使用。

官方服务状态发布声明称:近期 DeepSeek 线上服务受到大规模恶意攻击,注册可能繁忙,请稍等重试。已注册用户可以正常登录,感谢理解和支持。关于暂时无法注册的问题,DeepSeek回应称:近期 DeepSeek 线上服务受到大规模恶意攻击,注册可能繁忙,请稍等重试。已注册用户可以正常登录,感谢理解和支持。

网络安全领域公司奇安信近期监测发现「DeepSeek」在过去一个月内持续遭受大量来自海外的攻击。自 1 月 27 日起,攻击手段更是有所升级,除了 DDos 攻击外,还出现了大量的密码爆破攻击。

周鸿祎发声称攻击的行为“不要脸”。同时,他也承诺将提供更为安全的网络环境以保障「DeepSeek」的正常服务。不要朝初创公司下手,有本事试试 360 的专线机房啊。

网友看后也纷纷评论表示,建议 360 直接给攻击者电脑上全部安上小鸟壁纸。第二天,五角大楼里每个人都盯着桌面上的小鸟壁纸陷入了沉思。

因为「DeepSeek」是免费、开源、支持本地部署时私有的,所以本文教大家如何在自己的电脑上部署运行 DeepSeek-R1 模型。

部署教程

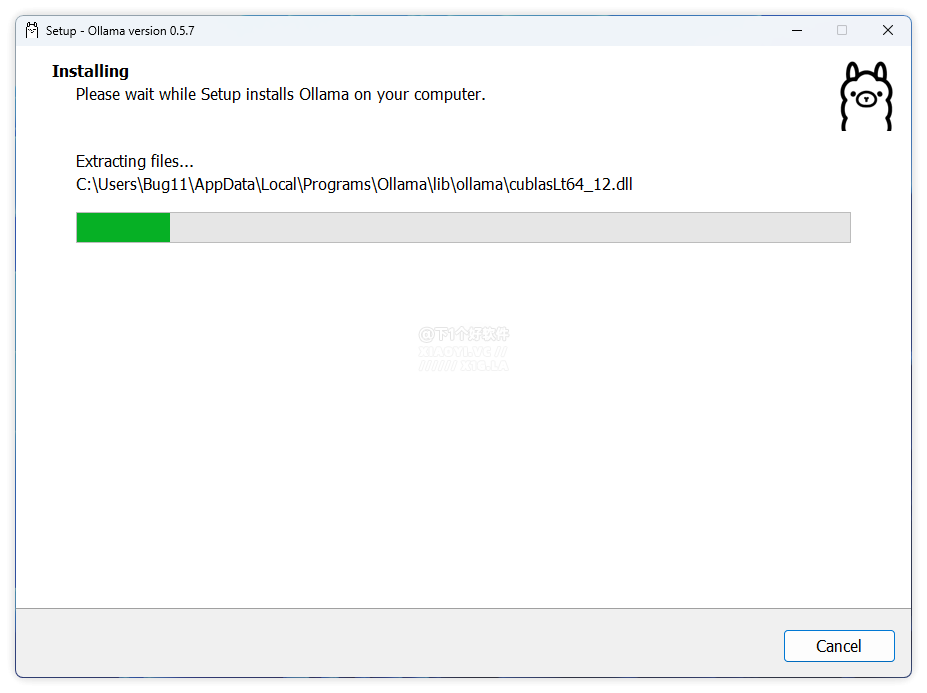

1.安装 Ollama 免费开源在本地轻松运行和部署大型语言模型的工具,并且支持 macOS、Linux 和 Windows,以及 Docker 容器化部署。用户还可以通过 Modelfile 修改模型参数,或基于现有模型微调。

- 网盘下载:

https://pan.quark.cn/s/a91827e20d18 - 官方网站:

https://ollama.com

使用 Ollama 建议你的电脑有 8GB 内存以上(7B 模型),下载完毕直接双击运行安装即可。

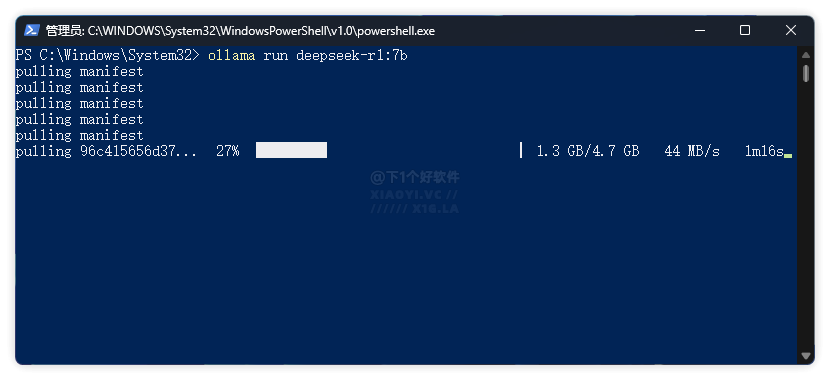

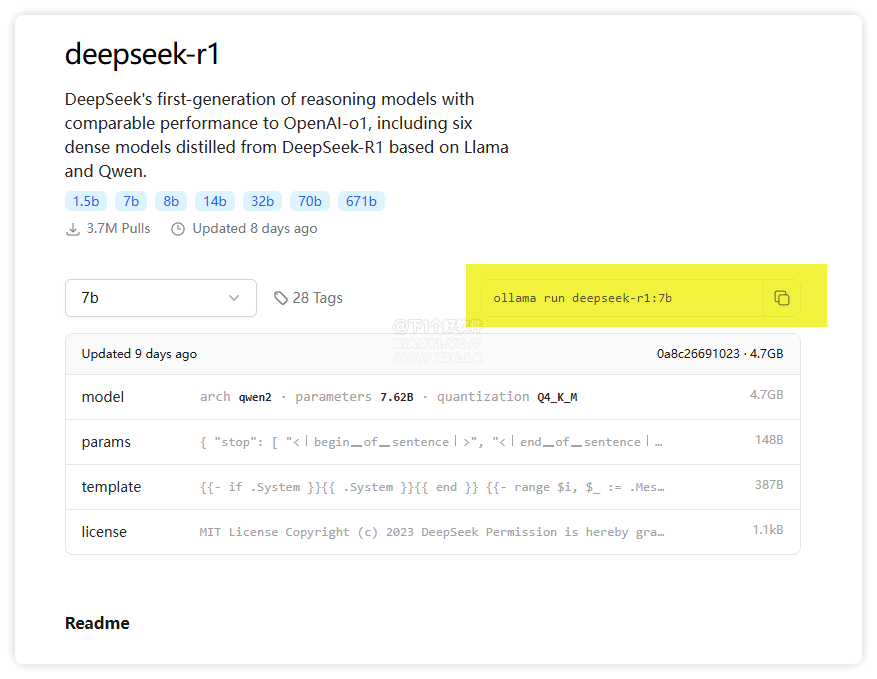

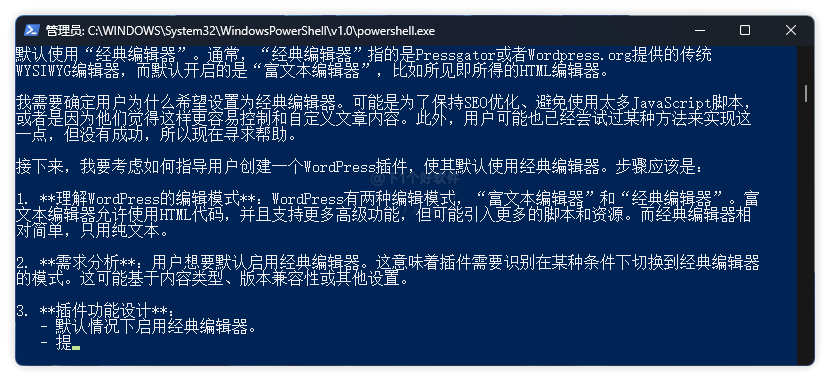

2.安装使用 DeepSeek-R1 模型,在终端输入命令:ollama run deepseek-r1:7b, 然后等待模型下载即可。

需要注意的是支持可选模型规格参数。PC 本地且推理能力较强推荐用 1.5b,7b,8b,14b 模型。你也可以通过添加参数的方式来下载其它模型,例如命令:ollama run deepseek - r1:8b。具体可以到 Ollama 网站的模型里面查看。

- 电脑配置有限:推荐使用 1.5B 或 7B 模型,可以在单张消费级显卡上运行。

- 更高的性能:可以选择 14B 或 32B 模型,但需要多 GPU 配置。

- 高端计算环境:可以选择 70B 模型,需要多张高端 GPU 支持。

3. 模型下载完毕后就可以在终端里输入问题提问了。实测 7B 适合中等规模的文本处理,如果你的电脑配置较高,建议安装 14B 或 32B 模型。

安装UI界面

如果你不想在终端里面使用「DeepSeek」模型,也可以安装一个 Web UI 界面,这里推荐这款「Page Assist」浏览器扩展插件,支持给本地 AI 模型提供网页界面。支持网络搜索功能、在侧边栏与 PDF 进行对话、与文档对话等功能。

安装好后,浏览器点击「Page Assist」插件,左上角选择「DeepSeek」模型,之后就可以开始问答了。

- Page Assist下载:

https://pan.quark.cn/s/30446a12bd2b

👉 DeepSeek 专题:DeepSeek 部署教程 / 免费 API 服务 / 入门指南