小米正式发布并开源全新 MoE 架构大模型 Xiaomi MiMo-V2-Flash。以 “极致效率” 为核心定位,在参数量、推理速度、任务性能与成本控制上实现多维突破。

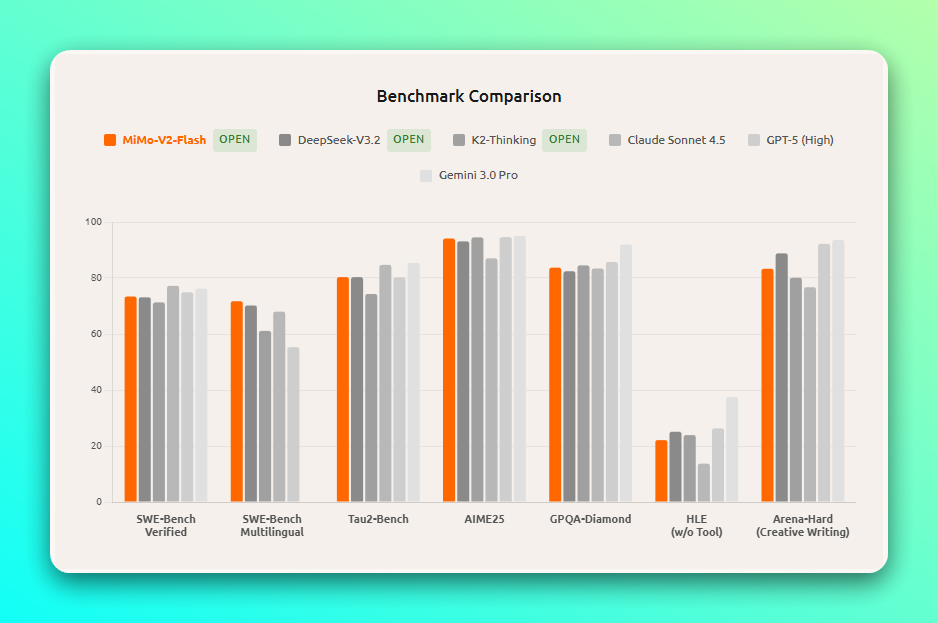

官方介绍称,这是一个专为极致推理效率自研的总参数 309B(激活 15B)的 MoE 模型,通过 Hybrid 注意力架构创新及多层 MTP 推理加速,在多个 Agent 测评基准上保持进入全球开源模型 Top 2。

代码能力超过所有开源模型,比肩标杆闭源模型 Claude 4.5 Sonnet,但推理成本仅为其 2.5%,生成速度提升 2 倍。性能还能媲美开源 DeepSeek-V3.2 模型。

模型核心规格

- 参数量级:总参数量达 3090 亿,为模型储备了充足的知识与任务处理能力;但实际推理时仅激活 150 亿参数,大幅降低计算资源消耗,避免传统大模型 “重推理” 的痛点。

- 上下文窗口:支持 256K 超长上下文,可处理相当于一本中等篇幅小说或数十页技术文档的文本量,满足多轮智能体交互、长文档分析等复杂场景需求。

- 开源协议与生态:基于 MIT 开源协议,模型权重(含 MiMo-V2-Flash-Base 版本)已完整发布于 Hugging Face,同时开源推理代码并贡献至 SGLang 框架,开发者可直接复用现有训练与推理基础设施,无需大规模重构。

API 接入

MiMo-V2-Flash API 开放平台兼容 OpenAI API、Anthropic API 两种主流格式,MiMo-V2-Flash 的 API 定价为输入 $0.1/M tokens,输出 $0.3/M tokens,API 限时免费。

在线体验

另外小米发布基于 Xiaomi MiMo-V2-Flash 在线 AI 聊天,无需代码即可体验模型 Xiaomi MiMo-V2-Flash 能力,支持聊天、创作、脑洞问答,具备深度思考与联网搜索功能,可实时核对信息、获取最新动态。

下载地址

- 在线体验:

https://aistudio.xiaomimimo.com/ - API 开放平台:

https://platform.xiaomimimo.com/ - HuggingFace 模型地址:

http://hf.co/XiaomiMiMo/MiMo-V2-Flash