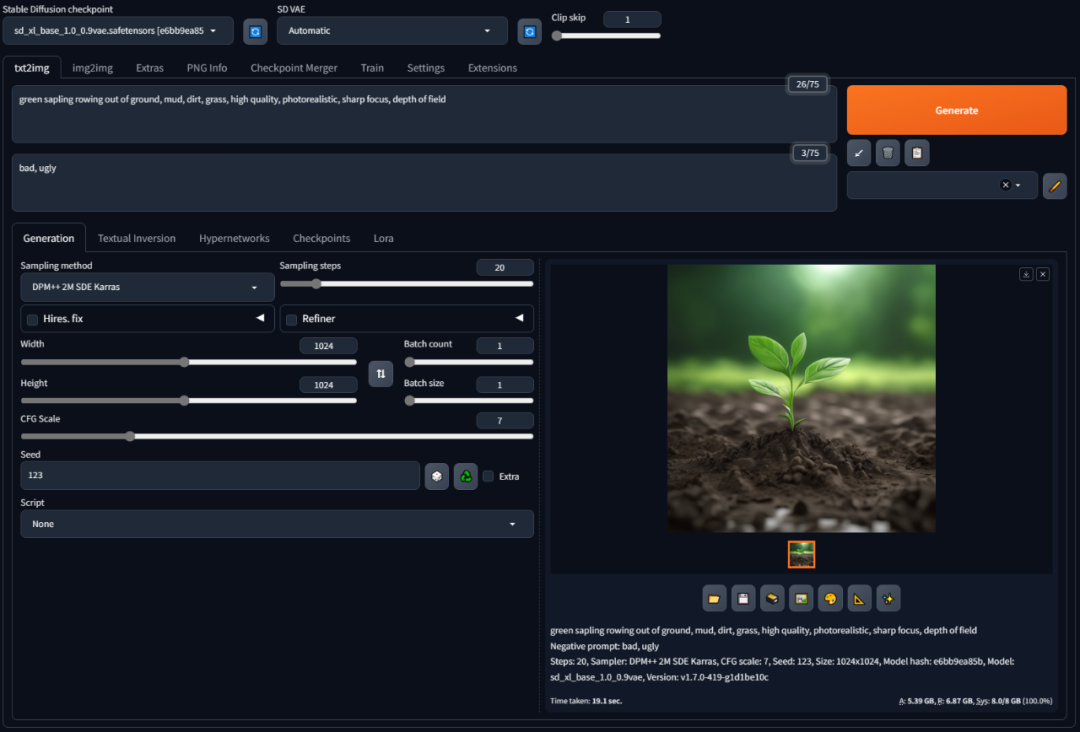

主流的 AI 文生图项目「Stable Diffusion」本地部署比较麻烦,所有就有了本地整合版,例如之前分享的:@秋葉aaaki 制作的整合版本,支持一键启动,内置非常多的模型。

但是这个整合版对显卡比较高,建议 RTX3060 以上的显卡。如果你显卡显存比较少的话,锋哥推荐由 Controlnet 推出的「WebUI Forge」版本,它与原始 WebUI 相比,能够实现显著的推断速度提升。

据介绍「WebUI Forge」优化 GPU 资源管理,生成速度比 WebUI 快了一倍左右。6G 显存的显卡的出图的推理速度提升了 60~75%,8 GB 的速度可提高 45%,24 GB 的速度可提高 6%。内存峰值最高可以下降 1.5G,低配显卡用户狂喜。

使用方法

下载后解压,然后第一次用先打开 update.bat 更新安装包,然后运行 run.bat 安装依赖环境,更具体建议看文末的视频教程。

在扩展处安装 layer,输入地址:https://github.com/layerdiffusion/sd-forge-layerdiffusion 安装成功后,重启启动器就可以使用了。

模型介绍

✅ LoRA 透明图像生成器:

- layer_xl_transparent_attn.safetensors:排名 256 的 LoRA 模型,将 SDXL 转换为透明图像生成器,改变模型潜在分布到可被特定 VAE 解码的“透明潜在空间”。

- layer_xl_transparent_conv.safetensors:替代模型,包含所有卷积层偏移量,可与 XL 模型合并,将潜在分布转为透明图像。在某些情况下,仍需特殊提示理解。

✅ 前景/背景生成模型:

- layer_xl_fg2ble.safetensors:将 SDXL 转为基于前景的融合图像生成模型。

- layer_xl_fgble2bg.safetensors:将 SDXL 转为基于前景和融合的背景生成模型。

- layer_xl_bg2ble.safetensors:将 SDXL 转为基于背景的融合图像生成模型。

- layer_xl_bgble2fg.safetensors:将 SDXL 转为基于背景和融合的前景生成模型。

✅ 透明度扩散模型:

- vae_transparent_encoder.safetensors:图像编码器,提取潜在偏移量,用于透明度扩散。

- vae_transparent_decoder.safetensors:图像解码器,输入为 SD VAE 输出和潜在图像,输出为真实 PNG 图像,设计更轻量级以减少 VRAM 需求。

下载地址

- Controlnet 项目地址:

https://github.com/lllyasviel/stable-diffusion-webui-forge - Controlnet 模型下载:

https://github.com/lllyasviel/stable-diffusion-webui-forge/wiki/ControlNet-model-download - Controlnet 网盘下载:

https://github.com/lllyasviel/stable-diffusion-webui-forge/wiki/ControlNet-model-download - Controlnet 视频教程:

https://www.bilibili.com/video/BV142421M7i3 - Controlnet 使用教程:

https://www.bilibili.com/video/BV1fa4y1G71W - 秋叶整合包 4.7:

https://pan.quark.cn/s/7543dd9d85fc